Chưa có sản phẩm trong giỏ hàng.

GPT (viết tắt của Generative Pre-training Transformer) là một mô hình tạo văn bản AI được viết bởi Alec Radford sau đó được phát triển tại OpenAI của Elon Musk. Năm 2018, GPT chính thức được ra mắt, nó sử dụng một mô hình ngôn ngữ tổng quát bao gồm hai mạng thần kinh tự cạnh tranh để hoàn thiện lẫn nhau. Chỉ dựa trên dữ liệu đầu vào hạn hẹp, GPT có thể tạo ra những đoạn văn bản hoàn chỉnh.

Tháng 2/2019, GPT-2 được ra mắt với mức độ hoàn thiện còn cao hơn. Trước đó, Elon Musk đã từ chối công bố GPT-2 bởi ông lo ngại nó có thể được dùng để tạo ra tin giả đăng tải lên các mạng xã hội.

Tháng 5/2020, OpneAI chính thức trình làng GPT-3 với khả năng xử lý 175 tỷ tham số so với 1,5 tỷ của GPT-2. Điều này đồng nghĩa với việc GPT-3 thông minh hơn và có khả năng tạo ra văn bản không khác gì con người.

Khi bạn đưa vào GPT-3 bất cứ tham số rời rạc nào bạn cũng sẽ nhận về một văn bản hoàn thiện, phù hợp nhất với những gì bạn đưa ra. Bạn có thể lập trình cho GPT-3 bằng cách nhập vào một số ví dụ về những gì bạn muốn và nó sẽ trả lại cho bạn một bài viết hoặc một câu chuyện hoàn chỉnh. Dưới đây là một đoạn văn ngắn được viết hoàn toàn bởi GPT-3:

GPT-3 có hiệu suất cao trên nhiều bộ dữ liệu NLP, bao gồm các nhiệm vụ liên quan tới dịch thuật, trả lời câu hỏi cũng như các nhiệm vụ cần lý luận nhanh hoặc chỉnh tên miền… GPT-3 có thể tạo ra các tin tức mà chúng ta không thể phân biệt được là do con người viết hay máy móc tạo ra. Đây cũng chính là điều mà OpenAI luôn lo ngại.

Hiện tại, GPT-3 cho phép dùng thử miễn phí và chuẩn bị ra mắt một bản dùng thử riêng có thu phí người dùng. OpenAI cho biết họ sẽ chấm dứt quyền truy cập API GPT-3 của các đối tượng sử dụng nó cho mục đích gây hại như tạo tin giả, quấy rối, spam…

Bên cạnh nguy cơ bị lợi dụng cho mục đích xấu, GPT-3 cũng khiến nhiều người lo sợ khi nó có thể lấy mất việc làm của nhiều người, đặc biệt là người viết kịch bản, các biên tập viên báo chí, nhân viên dịch thuật… Ngoài ra, các nhà phát triển AI còn tìm thấy một số ứng dụng đáng ngạc nhiên của GPT-3.

Ví dụ, nhà phát triển Sharif Shameem đã viết ra một trình tạo bố cục bằng GPT-3. Chỉ cần bạn nhập vào các mô tả đơn giản, GPT-3 sẽ tạo ra những dòng code phù hợp:

Tương tự như vậy, nhà phát triển Jordan Singer đã tạo ra công cụ có tên Figma bằng GPT-3. Công cụ này có thể tạo ra một ứng dụng chỉ dựa trên các mô tả đơn giản:

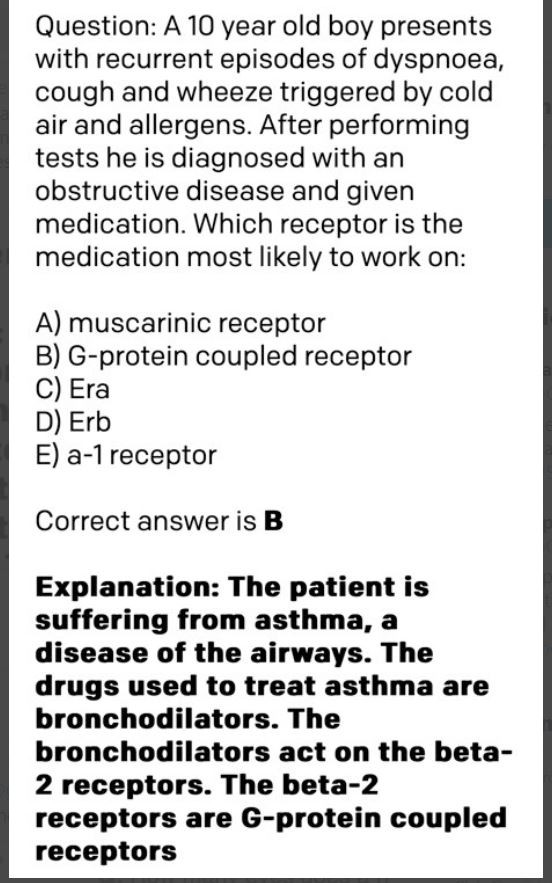

Thậm chí, GPT-3 còn có thể được dùng để chẩn đoán hen suyễn và kê đơn thuốc:

Ứng dụng khác của GPT-3 là tạo ra một công cụ tìm kiếm có thể trả lời mọi câu hỏi và thậm chí có thể được sử dụng để giải thích và mở rộng các khái niệm khó hiểu:

Rõ ràng, GPT-3 đang trên đà phát triển thành một AI có thể hiểu, lý luận và trò chuyện như con người. Tuy nhiên, OpenAI cảnh báo rằng các đối tác sẽ gặp một số vấn đề cơ bản khi nâng cấp lên GPT-3. Ví dụ, GPT-3 cần sức mạnh tính toán vài nghìn petaflop/1 giây hoặc 1 ngày trong khi GPT-2 chỉ cần vài chục petaflop/1 giây hoặc 1 ngày.

Nếu tiếp tục phát triển theo đà này, ngày mà AI cướp mất việc làm của chúng ta sẽ không còn xa nữa.

Nguồn: Đỗ Kỷ – quantrimang.com